Die Technologielandschaft ändert sich immer schneller, Entwicklungszeiten für neue Produkte werden kürzer, die Abstände, in denen Innovationen auf den Markt drängen, schrumpfen. Dies sind Trends, auf die gerade auch ein Elektronikdistributor reagieren muss, meint William Amelio, CEO von Avnet, dem Mutterkonzern von EBV. Amelio, der seit Sommer 2016 Vorstandsvorsitzender von Avnet ist, hat daher ein umfangreiches Programm gestartet, mit dem er das gesamte Unternehmen einer echten Transformation unterziehen will: Rund 450 Projekte sollen die Beziehungen zu den Kunden noch weiter vertiefen und dabei helfen, ihre Bedürfnisse noch besser umzusetzen und ihnen noch mehr Services zu bieten. „Wir sind die Ersten, die als Elektronik-Distributor echte End-to-End-Lösungen anbieten, mit denen wir eine Produktidee von den ersten Prototypen bis zur Massenfertigung begleiten. Um das zu erreichen, mussten wir einige signifikante Veränderungen als Unternehmen realisieren“, so Amelio. Sein Ziel: Avnet soll zu einem „Innovationsvermittler“ werden. Künstliche Intelligenz ist dabei für den Manager ein wichtiger Baustein – als Marktsegment, aber vor allem auch für sein Unternehmen selbst, wie er im Interview erläutert.

Welchen Einfluss wird Künstliche Intelligenz aus Ihrer Sicht in Zukunft auf die Technologie und unser Leben im Allgemeinen haben?

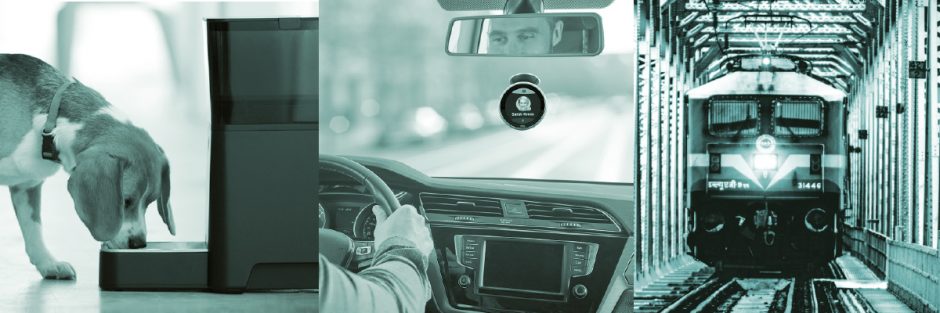

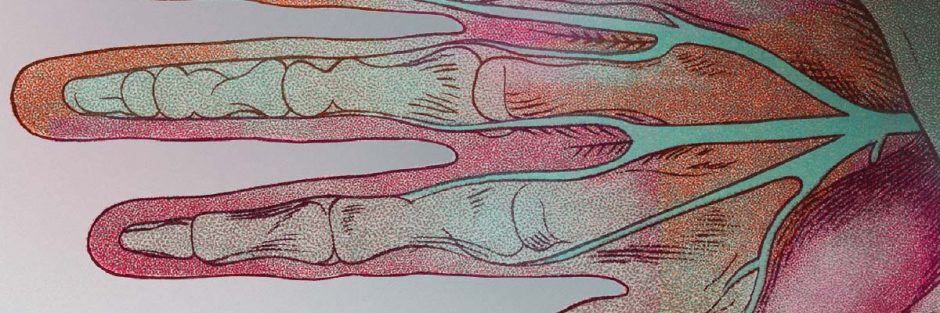

William Amelio: Zukunftsforscher sagen, dass KI einen größeren Einfluss auf die Gesellschaft haben wird als die industrielle und digitale Revolution. Aktuell beobachten wir immer mehr konkrete Beispiele, die zeigen, wie das aussehen könnte. Denn die Technologien, die KI-Systemen die nötige Leistung verleihen, werden heute immer bezahlbarer und sind zunehmend frei zugänglich. KI ermöglicht bereits stärker personalisierte Medikations- und Behandlungspläne im Gesundheitswesen. Die Fahrzeuge auf unseren Straßen werden vermehrt autonom. Auch Gesichts-, Stimm- und Fingerabdruck-Erkennung gehören immer mehr zum Alltag. Noch liefert KI die Informationen an uns und wir treffen die letzte Entscheidung. Mit der Zeit werden diese Applikationen so ausgestattet, dass sie mehr für uns entscheiden, so dass wir – zumindest in der Theorie – mehr Zeit für wirklich wichtige Denkaufgaben haben.

Da KI sich in den nächsten Jahren in immer mehr Anwendungen etablieren wird, wird ihr Einfluss exponentiell wachsen, insbesondere in Bereichen wie dem Arbeitsmarkt. Wenn Landwirte die Effizienz ihrer Felder maximieren können oder sich ständig wiederholende Bürotätigkeiten automatisiert werden, wird das dramatischen Einfluss darauf haben, wie wir unsere Arbeit managen. Zudem wird KI neue Herausforderungen im öffentlichen Bereich bringen. Auch wenn die Meinungen bezüglich Umfang und Zeitpunkt auseinandergehen, hat KI die Fähigkeit und das Potenzial, uns dabei zu helfen, viele der komplexen Probleme zu lösen, die unsere Gesellschaft plagen.

Welche Rolle spielt KI-Technologie im Speziellen für Avnet als Elektronik-Distributor?

W. A.: KI wird uns helfen, unsere Geschäftstätigkeiten zu optimieren, die Zufriedenheit unserer Kunden und Mitarbeiter zu steigern und neue Marktchancen zutage fördern. Heute forschen wir an dem Einsatz von Datenbank-Modellen für eine personalisierte Preisgestaltung, für das automatisierte Bezahlen und zum Managen und Vorhersagen von Kundenbedürfnissen. Wir haben ein Pilotprojekt gestartet, in dem sich wiederholende Aufgaben automatisiert werden, die keinen Beitrag zu unserer Wertschöpfung oder zur Zufriedenheit unserer Mitarbeiter leisten. KI kann uns auch helfen, Prognosen zu treffen und stärker personalisierte Angebote sowie Services für unsere Kunden, Lieferanten und für unsere Mitarbeiter anzubieten.

Wir werden zudem in der Lage sein, Prozesse zu beschleunigen und zu automatisieren, indem einige Entscheidungen an Maschinen übertragen werden.

Insbesondere glaube ich, dass Lieferketten als Ergebnis einer Kombination neuer Technologien – inklusive KI – eine komplette Metamorphose durchlaufen werden. Viele der frühen Versprechungen der KI laufen auf eine verbesserte Entscheidungsfindung hinaus. Das ist ebenso ein Gebiet, in dem KI die Unternehmensführung und kultur signifikant beeinflussen wird.

Welchen Einfluss hat KI-Technologie auf Ihr Produktportfolio?

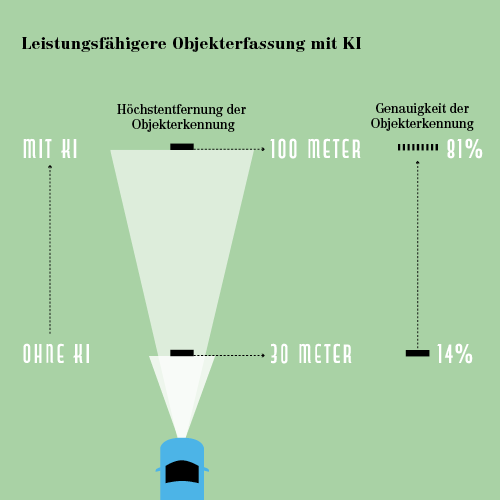

W.A.: KI beginnt sicherlich, einen Bedarf für neue Technologien zu generieren, was wiederum neue Marktchancen eröffnet. Zum Beispiel verbessert unsere neue „Avnet MiniZed Zync SoC“-Plattform die Leistung der Geräusch-Erfassung für KI-Anwendungen. Es nutzt Technologien von Xilinx und Aaware, um eine schnellere, sicherere Fernbereichs-Voice-Schnittstelle zu schaffen. Unter unseren wichtigsten Lieferanten können wir beobachten, dass KI sowohl Hardware- als auch Software-Produkte vorantreibt. Dazu gehören sowohl FPGA-Kits als auch kundenspezifische Chips zur Hartkodierung von neuronalen Netzwerken für KI. Viele Unternehmen designen zudem KI-spezifische Chips. Darin spiegelt sich ein größerer Trend, eine gewisse Intelligenz in die Geräte zu verlegen, statt sie vollständig in der Cloud zu halten. Das löst den Konflikt zwischen Latenz und Kosten auf der einen Seite und Größe an Rechen-Power, die diese Anwendungen erfordern, auf der anderen Seite. Nicht nur, dass Risikokapitalgeber Start-ups in diesem Bereich unterstützen, sondern auch Technologie-Schwergewichte wie Intel, Google, Apple und Microsoft mischen bei kundenspezifischen Chips mit. Viele sind bereits in unserer Linecard.

„Wir müssen eine neue Generation an Führungskräften formen, die versteht, wie man mit KI arbeitet.“

Wird KI darüber hinaus Veränderungen für Avnet bedeuten?

W.A.: Ich habe gerade schon erwähnt, dass KI erheblichen Einfluss auf die Unternehmenskultur und -führung haben wird. Denn die Art, wie wir arbeiten, Entscheidungen treffen und unsere Geschäftsmodelle strukturieren, wird durch KI verändert. Um dahin zu kommen, müssen wir eine neue Generation an Führungskräften formen, die versteht, wie man mit KI arbeitet. Das bedeutet, es müssen neue Kompetenzen erworben und einige der vorhandenen weiterentwickelt werden, um die neuen Vorteile wirklich zu verstehen, die KI mit sich bringt.

So kann KI zum Beispiel dabei helfen, die Mitarbeiterzufriedenheit zu prognostizieren und die Arbeitsbelastung entsprechend auszubalancieren. Wir erhalten zudem viel schneller und regelmäßiger Einblick in Kundenbefragungen, da wir nicht mehr durch so ein arbeitsaufwändiges Data-Mining gehen müssen. Doch sind die Prozesse eines Unternehmens und die Talente, die benötigt werden, damit Personalentwicklung und Kundenservice auf diese Art arbeiten, heute schon vorhanden? Wahrscheinlich nicht.

KI kann sehr viel für uns tun, aber wir müssen erst lernen, wie man damit arbeitet. Die Art, wie wir unsere Geschäfte machen, wird in zehn Jahren ziemlich anders aussehen. Jeder von uns muss bereit für eine persönliche Reise mit vielen Veränderungen und kontinuierlichem Lernen sein.

Avnet nutzt bereits AI in der Plattform Ask Avnet. Können Sie uns kurz erklären, was Ask Avnet ist und wie Ihre Kunden davon profitieren?

W.A.: Ask Avnet ist ein intelligenter Assistent, der durch eine Kombination von KI und menschlicher Expertise unsere Kunden optimal unterstützt. Unsere Kunden können so eine große Bandbreite an Fragen stellen, ohne einen Hürdenlauf durch den Kundenservice machen zu müssen. Ask Avnet kann den Kunden nahtlos durch unsere verschiedenen digitalen Kanäle bewegen. Unsere Kunden können immer noch die gleichen Seiten nutzen, während Ask Avnet sie mit den Ressourcen unseres gesamten breiten Ecosystems vernetzt. Wir sehen bereits vielversprechende Ergebnisse wie eine reduzierte Fehlerzahl. Da Ask Avnet mit der Zeit immer mehr dazu lernt, wird es uns helfen, einen besser skalierbaren, effizienten und ansprechenden Kundenservice anzubieten.

Noch wichtiger ist, dass Ask Avnet entwickelt wurde, um den Kontext der Kunden-Anforderungen zu verstehen und seine Antworten entsprechend maßzuschneidern. Es macht Personalisierung möglich, und das führt zu einem signifikanten Mehrwert, der mit der Zeit nur wachsen kann. Das System kann kontextuell verstehen, in welchem Stadium der Produktentwicklung unsere Kunden sind. So kann Ask Avnet proaktiv Informationen identifizieren, die nützlich für unsere Kunden sind, auch wenn sie nicht notwendigerweise bewusst danach gesucht haben – wie zur Produktreife oder zu prognostizierten Lieferzeiten. Es lernt kontinuierlich durch neue Anfragen bzw. Erfahrungen und liefert ständig die neuesten Einblicke während sich Anforderungen, Technologien und Märkte entwickeln.

Ask Avnet greift auch auf das Know-how der Plattformen hackster.io und element14 zurück. Wie wichtig sind diese Akquisitionen aus 2016 für das mit Ask Avnet verfolgte Ziel, die Time-to-Market für Ihre Kunden zu reduzieren?

W.A.: Ask Avnet ist ein weiterer Weg für unsere Kunden, Zugriff auf die Fülle an Informationen zu erhalten, die über unser Avnet Ecosystem zur Verfügung gestellt wird. Die von Ihnen genannten Communities sind ein wichtiger Teil dieses Ecosystems. Letztlich erweitert es die Aufgabe unserer Communities, wobei es mehr Proaktivität und Personalisierung einführt. Wenn man in unseren Communities ist, befindet man sich auf einer Sondierungsreise. Wenn man Ask Avnet nutzt, hat man einen KI-gestützten Guide, der die Informationen liefert, die man benötigt.

Indem wir Ask Avnet mit unseren Online-Communities kombinieren, helfen wir, die Time-to-Market unserer Kunden zu verkürzen. Denn damit sind die Ressourcen, die sie zur Lösung ihrer Herausforderungen benötigen, ohne weiteres verfügbar, leicht zugänglich und relevant.

„KI hat die Fähigkeit und das Potenzial, uns dabei zu helfen, viele der komplexen Probleme zu lösen, die unsere Gesellschaft plagen.“

Die Beta-Version von Ask Avnet ging im Juli 2017 online. Wie sind die bisherigen Erfahrungen Ihrer Kunden?

W.A.: Der Kundennutzen wird immer besser, da der intelligente Assistent von jeder Anfrage lernt. Unsere Kunden profitieren immer mehr von dem Tool, während sowohl der Gebrauch als auch die Kunden-Zufriedenheit zunehmen. Es ist in der Lage, detailliertere und längere Unterhaltungen zu führen, während sich die Art der Fragen, die Ask Avnet beantworten kann, signifikant erweitert hat. Es ist sogar in der Lage, tiefer in Fragestellungen einzutauchen.

Zum Beispiel hat Ask Avnet in der Startphase eine Anfrage mit einer Liste von Empfehlungen beantwortet. Heute antwortet Ask Avnet mit relevanteren Fragen, um die Kundenanfragen zu klären und Optionen einzugrenzen, bevor es Empfehlungen liefert. Es kann zudem kontextuell relevante Informationen einbinden wie How-to-Projekte von unseren Communities, Preise, Bestände oder Lieferzeiten. Während es lernt, liefert Ask Avnet mehr Informationen und führt qualitativ immer höherwertige Unterhaltungen.

Wird es in Zukunft weitere Projekte geben, in denen KI für Prozesse bei Avnet genutzt werden?

W.A.: Ohne Zweifel. Zurzeit konzentrieren wir uns auf die Projekte, die den höchsten Nutzwert für unsere Zielgruppen haben, was sowohl Front-Office- als auch Back-Office-Projekte beinhaltet. Wir schauen auf Nachfragesteuerung, Lieferketten-Optimierung und setzen die Arbeit zur Verbesserung des Kundennutzens mit Ask Avnet und anderen Projekten fort. Die Technologie ist wirklich überall einsetzbar, wo es Chancen zur Verbesserung der Effizienz sowie zum Reduzieren von Langeweile gibt und wo wir unseren Mitarbeitern helfen können, mehr Wert zu schaffen.

Welche Auswirkungen auf unser Leben wird KI Ihrer Meinung nach in Zukunft haben?

W.A.: Immer wenn man denkt, Innovation nimmt ab, etabliert sich ein neuer Trend – wie jetzt KI. Für mich ist es klar, dass der ökonomische und soziale Nutzwert von KI gerade erst am Anfang ist. Welches Argument einen auch immer bewegt, so können wir alle doch darin übereinstimmen, dass KI fundamental die Natur unseres Lebens und unserer Arbeit verändern wird. Das bedeutet, wir müssen neue Geschäftsmodelle erkunden und praktische Erfahrungen und Kompetenzen anwerben. Start-ups, Hersteller, Tech-Giganten und Traditionsbetriebe sind alle im gleichen Spiel. Der Wettbewerb wird neue und innovative KI-Ideen und -Anwendungen hervorbringen. Ich bin gespannt, das nächste Kapitel dieser Geschichte zu sehen!

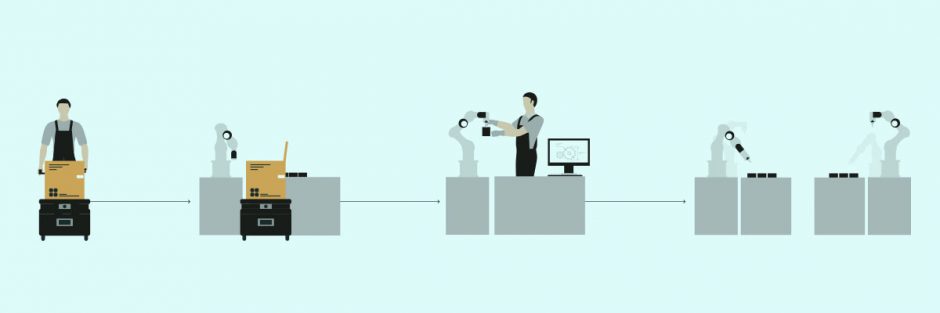

Von der ersten Skizze bis zur Massenproduktion

Von der Idee zum Design, vom Prototyp zur Produktion – Avnet unterstützt seine Kunden in jeder Phase des Produktlebenszyklus. Als einer der weltweit größten Distributoren für Elektronikkomponenten und Embedded-Lösungen bietet das Unternehmen neben den elektronischen Bausteinen ein umfassendes Portfolio an Design- und Supply-Chain-Services. Mit den in 2016 übernommenen Online-Communities Hackster.io und Element14 schlägt Avnet zudem Brücken zwischen der Welt der Maker und der der Hersteller. Hackster.io hat es sich zur Aufgabe gemacht, jungen Unternehmen dabei zu helfen, Hardware für IoT-Designs zu entwickeln. Das Netzwerk ist mit rund 90 Technologie-Partnern verbunden und umfasst fast 200.000 Ingenieure, Maker und Hobby-Techniker. Element14 ist eine Engineering-Community mit über 430.000 Mitgliedern. Die Akquise beider Plattformen ist ein wichtiger Baustein des Unternehmensziels, den Kunden dabei zu helfen, mit einer Idee als Erster auf dem Markt zu sein. Dabei kann auf ein über fast 100 Jahre eng geknüpftes Netzwerk an führenden Technologie-Unternehmen weltweit zurückgegriffen werden.

Der Hauptsitz von Avnet befindet sich in Phoenix, Arizona. Gegründet wurde das Unternehmen 1921 von Charles Avnet als kleines Ladengeschäft in Manhattan, das sich auf den Verkauf von Komponenten für Radios spezialisiert hatte. Heute beschäftigt Avnet mehr als 15.000 Mitarbeiter und ist in 125 Ländern in Nordamerika, Europa und Asien vertreten.