Der Blick in die Zukunft ist immer von Unsicherheit geprägt. „Die Zukunft als Ganzes und im Detail kann man natürlich nicht voraussagen“, meint Matthias Horx. „Aber man kann Scheinwerferkegel in die Zukunft werfen.“ Horx gilt als einflussreichster Trend- und Zukunftsforscher im deutschsprachigen Raum. Nach einer Laufbahn als Journalist gründete er zur Jahrtausendwende das „Zukunftsinstitut”, das zahlreiche Unternehmen und Institutionen berät. Heute sieht er sein Lebensprojekt darin, die Futurologie der 60er und 70er Jahre zu einer Consulting-Disziplin für Unternehmen, Gesellschaft und Politik weiterzuentwickeln. Gerade bei der Betrachtung zukünftiger Technologien setzt er auf einen „evolutionären“ Ansatz: Die Zukunft ist nicht das Ende einer geraden Linie, Altes wird nicht einfach durch Neues ersetzt. Vielmehr entwickeln sich menschliche Fähigkeiten und Bedürfnisse und die Angebote der Technik gemeinsam weiter. Die Zukunft entsteht so in immer neuen Kombinationen und Re-Kombinationen, von denen einige sich durchsetzen, andere aber -verworfen werden. Unter diesem Aspekt warf das Zukunftsinstitut für den ADAC auch einen „Schweinwerferkegel“ auf die Perspektiven der Mobilität. Die Studie „Die Evolution der Mobilität“ schaut bis zum Jahr 2040 – und prognostiziert einen tiefgreifenden Wandel für die Mobilität. Danach stehen wir am Beginn eines neuen multimobilen Zeitalters. Im Interview mit The Quintessence erzählt Matthias Horx, was darunter zu verstehen ist und welche Rolle autonome Fahrzeuge dabei spielen.

„Wenn man wirklich verstehen will, wie die Zukunft aussieht, muss man die Wechselwirkung von sozialen und technischen Prozessen verstehen.“

The Quintessence: Sie betrachten in Ihrem Zukunftsinstitut vielfältige Themen – erkennen Sie übergreifende Trends?

Matthias Horx: Es gibt Modetrends, sozioökonomische Trends, Techniktrends und Megatrends, das sind die Langfristtreiber des Wandels wie etwa die Globalisierung oder die Urbanisierung. Und dann gibt es noch Metatrends, die langfristig die ganze Evolution antreiben. Herman Kahn, der berühmte Zukunftsforscher der 60er Jahre, hat einmal vom „Langfristig Komplexen Trend” gesprochen. Das ist vielleicht sogar das Evolutionsprinzip selbst, also eine Art Weltformel: Immer mehr Komplexität. Wobei man Komplexität nicht mit Kompliziertheit verwechseln darf!

Welche Rolle spielen technologische Entwicklungen bei Ihren Blicken in die Zukunft?

M. H.: Technologie ist ein wichtiger Veränderungsmotor, aber eben nicht der einzige. Wenn man wirklich verstehen will, wie die Zukunft aussieht, muss man die Wechselwirkung von sozialen und technischen Prozessen verstehen. Nicht alle Innovationen setzen sich am Markt durch. Momentan haben wir zum Beispiel einen Hype von Robotern, die immer menschenähnlicher aussehen. Ich prognostiziere: Das wird ein Flop. Wir sind zwar einerseits fasziniert von „Künstlichen Menschen”, aber andererseits gruselt es uns auch davor. Das ist ein natürlicher Anti-Reflex. Und wird die Blech- und Plastikkameraden irgendwann zurück in die Labore schicken. Dafür werden sie sich als Industrieroboter in den Fabriken überall durchsetzen.

„Ich vermute, dass wir erst einmal 20, 30 Jahre pilotiert fahren und die volle Autonomie erst um 2040 oder 2050 einen echten Durchbruch erleben wird.“

Wie wird die Mobilität von morgen aussehen?

M. H.: Generell wird Mobilität sich entmaterialisieren und kulturisieren. Sie wird heute noch eher als funktionale Bewegung von A nach B wahrgenommen. Man fährt überwiegend, weil man „Strecken” zurücklegen muss. Aber das ändert sich. Man kann Distanzen auch immer mehr mit virtuellen Techniken überbrücken, mit Telepräsenz. Wir erleben andererseits auch ein neues Nomadentum, Menschen die immer unterwegs sind und daraus eine Lebensform gemacht haben. Mobilität ist ein Lifestyle.

Welche Rolle spielen dabei autonome Fahrzeuge insgesamt – also auch Schiffe, Flugzeuge oder Bahnen?

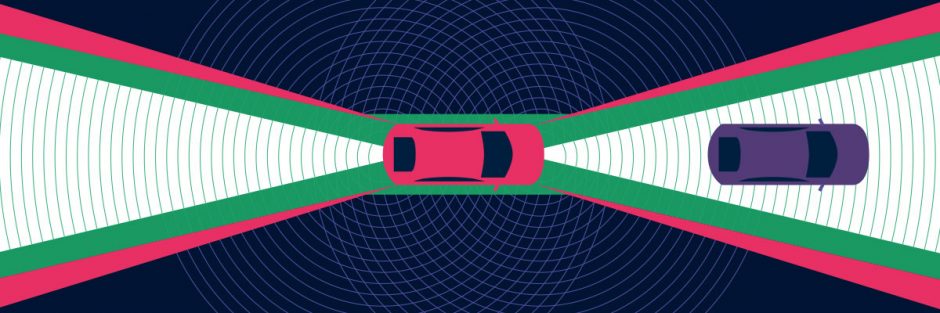

M. H.: Wir können davon ausgehen, dass es in allen diesen Bereichen autonomes Fahren geben wird, die Frage ist nur wann. Es könnte sein, dass Schiffe sich sogar besser für die Vollautomatik eignen als Autos. Beim Straßenverkehr ist die Komplexität eben doch gigantisch. Ich vermute, dass wir erst einmal 20, 30 Jahre pilotiert fahren und die volle Autonomie erst um 2040 oder 2050 einen echten Durchbruch erleben wird. Aber dann muss es schnell gehen, denn eine Mischsituation mit teilweisen Selbstfahrern, teilweisen autonomen Fahrzeugen ist systemisch unwahrscheinlich. Bis 2040 werden aber wohl schon die meisten Schienenfahrzeuge automatisch fahren, das ist technisch viel leichter.

Gab es in der Studie „Evolution der Mobilität“ Ergebnisse beziehungsweise Erkenntnisse, die Sie überrascht haben?

M. H.: Es war schon überraschend, wie deutlich die Bereitschaft der Menschen zu einer anderen Mobilität war. Die Menschen sind, was das Autofahren angeht, extrem gespalten. Einerseits gibt es immer noch 40 Prozent richtige Autofanatiker, für die das Autobesitzen eine undiskutierbare Identitätsfrage ist. Sozusagen die Taliban des Verbrennungsmotors. Andererseits sind die Vielautofahrer enorm durch die Staus genervt, und jetzt kommt auch noch die Dieseldebatte. Es gibt besonders in den Städten einen doch recht hohen Anteil von Leuten, die froh sind, kein Auto mehr zu besitzen – die das geradezu als Befreiung und Lebensqualität begreifen.

Haben Sie in der Studie nur den Straßenverkehr betrachtet?

M. H.: Das war natürlich ein Schwerpunkt, wobei es uns um ein ganzheitliches Verständnis von Mobilitätsprozessen geht. Straßenverkehr ist ja heute noch weitgehend Autoverkehr. Das wird nicht so bleiben. Wir stehen vor der „Kopenhagenisierung” der Städte. Da spielen Autos nur noch eine Rolle am Rande, die Straße gehört dann Fußgängern, Radlern und fliegenden Händlern …

In dem Zusammenhang sprechen sie auch von einer multimodalen Mobilität. Was verstehen Sie darunter?

M. H.: Schlichtweg die nahtlose Verbindung von verschiedenen Verkehrsmitteln

bis zum Ziel, jederzeit einsetzbar und kombinierbar. Das Tolle am Auto ist ja, dass man von A nach B gelangen kann – mit Gepäck. Das geht in Zukunft auch ohne allzu großen Aufwand mit einer Kombination von, sagen wir – Elektroroller und Lastfahrrad und Zug und Drohne …

Viele Analysten sehen den Zenit der AutomobilBranche in zehn bis 15 Jahren erreicht. Welche Rolle spielt aus Ihrer Sicht das Auto in 2040?

M. H.: Mit solchen Formulierungen wäre ich vorsichtig. Denn einerseits ist die Autobranche schon jetzt an ihrem Zenit angelangt – so, wie sie heute ist, geht es nicht mehr weiter. Aber die Autobranche wird sich ja wandeln, sie wird mit der Energiebranche und der Computerbranche verschmelzen, und dann nennen wir sie vielleicht ganz anders …

Wie werden sich autonome Fahrzeuge auf unser Leben auswirken?

M. H.: Wir tun viele Dinge im Auto, die wir früher im Büro oder zu Hause getan haben. Schlafen, lieben, arbeiten … Allerdings ist das auch heikel, weil zum Beispiel unklar ist, ob das Autofahren nicht irgendwann zur Arbeitszeit dazugehört. Weshalb viele Menschen das Autofahren ja lieben, ist, dass es eine gewisse Entspannungsqualität hat, jedenfalls wenn der Verkehr fließt. Man kann sitzen und Musik hören, als Mitfahrer dösen, befindet sich also in einer sehr unterkomplexen Intensität der Handlung. Das wird von vielen Menschen als Erholung und Autonomie wahrgenommen. Das selbstfahrende Auto könnte das abschaffen, und deshalb sind viele Menschen instinktiv dagegen. Ein anderer Teil mag das Autonom-Auto nicht, weil es die Aggressivität des Autofahrens zerstört. Man kann nicht mehr steuern und rasen, und das Lichthupen auf der Autobahn ist vorbei. Wohin dann mit der ganzen inneren Wut?

Aber werden uns autonome Fahrzeuge nicht auch mehr Freiheiten ermöglichen?

M. H.: Die Freiheit, nicht mehr ganze Jahre seines Lebens mit dem Steuern und Bedienen eines Automobils zu verbringen, wäre eigentlich eine große Befreiung. Allerdings hätte man das auch mit dem Zug, und viele Menschen lieben ihren Sklavenstatus, so wie ja auch viele Menschen es sogar zu genießen scheinen, im Auftrag der Firma Ikea selbst Möbel zu bauen. Wir sind eigentlich ganz gern abhängig von Technologie, die Freiheit ist da wohl zweitrangig. Sonst würden die Menschen diese bizarren Stauerfahrungen wohl nicht hinnehmen.

Hand aufs Herz. Welche Entwicklungen haben Sie persönlich am meisten überrascht, weil Sie diese so gar nicht erwartet hatten?

M. H.: Trump.

Eines Ihrer Bücher heißt „Anleitung zum Zukunftsoptimismus“. Warum sollten wir optimistischer in die Zukunft blicken?

M. H.: Optimismus ist an sich ziemlich blöde, weil meistens blauäugig. Die Klügeren unserer Vorfahren waren keine Optimisten, sonst wären sie vor dem Alter tot gewesen, in dem sie sich fortpflanzen konnten. Ich bin Possibilist. Ich denke in Möglichkeiten und wähle die besseren als die Zukunftsperspektiven, die wir anstreben sollten.

Mobilität 2040: digital organisiert und individuell vernetzt

„Die Herausforderungen für die Mobilität der Zukunft liegen in der individuellen, intelligenten Vernetzung“, so ADAC-Präsident Dr. August Markl anlässlich der Vorstellung der vom Zukunftsinstitut erstellten Studie „Die Evolution der Mobilität“. „Unsere Mobilitätsmuster werden vielschichtiger und komplexer. Uns steht dabei keine disruptive Mobilitätswende bevor, sondern eine evolutionäre Entwicklung und Veränderung, die umso tiefgreifender und grundlegender sein wird.“

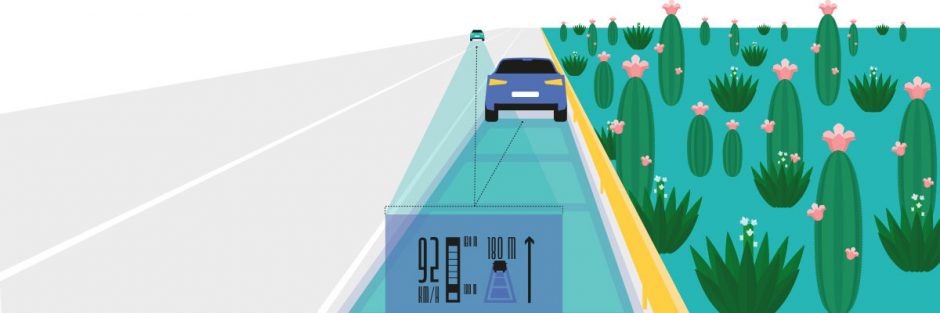

Das Bedürfnis nach Sicherheit, Gesundheit, intakter Umwelt und allgemeiner Lebensqualität wird in den kommenden Jahrzehnten weiter an Bedeutung gewinnen, so die Zukunftsstudie. Die Digitalisierung wird zur zentralen Grundlage der Mobilität von morgen. Bei steigendem Mobilitätsbedarf rechnen die Zukunftsforscher bis zum Jahr 2040 auch mit Veränderungen bei der bisherigen Autonutzung. Erwartet wird eine viel stärkere Vernetzung verschiedener Verkehrsträger bei der individuellen Fortbewegung. ÖPNV und Sharing-Angebote werden über digitale Plattformen integriert.

Auch die Entwicklung neuer Lebensstile, bedingt unter anderem durch eine veränderte Arbeitsweise oder die zunehmende Lebensdauer, wirken sich langfristig auf individuelle Mobilitätsmuster aus. Die Forscher rechnen bis 2040 mit vielfältigen Typen und Ausprägungen persönlicher Mobilität. Diese reichen von informationstechnisch versierten „Mobile Innovators“ bis hin zu „Silver Movern“, der anspruchsvollen Gruppe der Mobilen über 75-Jährigen.

Die komplette Studie „Die Evolution der Mobilität“ steht unter www.mobilitaet-2040.de zur Verfügung.